1. Indholdsfortegnelse

2. Introduktion

2.1. Formål

Formålet med dette dokument er at beskrive systemarkitekturen for GM-BFF.

2.2. Læsevejledning

Nærværende dokument er tiltænkt udviklere og IT-arkitekter med interesse i GM-BFF og dens opbygning.

2.3. Definitioner og referencer

| NSP | National Service Platform |

| GM | Graviditetsmappen |

3. Overblik over GM-BFF

Graviditetsmappens Backend For Frontend (GM-BFF) er en service, som skal servicere MinGraviditet app. Den følger BFF mønsteret (https://samnewman.io/patterns/architectural/bff/), hvilket resulterer i en række operationer, der stiller data til rådighed i klumper tilpasset klientens (appens) behov, uanset at disse kan komme fra flere datakilder eller i strukturer der ikke egner sig til appens brug. BFF'en har til opgave at sammenstille og omforme data efter appens behov.

BFF'en henter data fra 2 kilder: gm-facade på NSP for journaldata og CMS for artikler og tekster. Journal data caches i en lokal database, for at undgå gentagne opslag efter de samme data. BFF udstiller søgning i CMS via Meilisearch.

3.1. Løsningens afhængigheder

BFF'en udstilles som en Spring Boot server med et REST API.

CMS er en Strapi (https://strapi.io/) instans, hostet i samme kubernetes miljø som BFF'en. Strapi stiller et API til rådighed til udlæsning af ressourcer i Strapi, fx kategorier, artikler eller tjeklister. API'et er et REST agtigt api med en lidt speciel syntaks for søgninger og specificering af returnerede værdier. Disse særheder gemmes bag BFF'en, så appen kan få et API der er lettere at arbejde med.

gm-facade komponenten ligger på NSP, og udstiller en FHIR model for graviditetsmappen. Da der ikke er indført et forløbsbegreb eller lignende strukturerende begreber, er der kun én operation på gm-facade, nemlig "hent hele journalen for den angivne borger". Denne udstilles i en FHIR model som BFF læser og omformer til en intern model, der benyttes til de enkelte operationer på BFF.

3.2. Løsningens arkitektur

Internt er BFF'en struktureret i delkomponenter som følger:

- Controllere: API'et specificeret i OpenAPI, og ud fra dette genereres model-klasser og API interfaces. Disse API interfaces implementeres af Controllere, hvis formål er at udstille operationerne på BFF web servicen.

- Config: Applikationen er en Spring Boot applikation, så en del aspekter er sat op gennem konfiguration og interceptorer, deriblandt sikkerhed og logning.

- Integrationer: Der skal kaldes til eksterne services i form af CMS og gm-facade.

- Mappere: For at oversætte de interne modeller til API'ets modeller foretages mapning fra interne model-klasser eller kaldte services modeller til BFF API'ets genererede model-klasser.

- Journal Translator: gm-facadens FHIR model oversættes til en intern model, der er nemmere at arbejde med.

- Journal Logic: Udledning af terminsdatoer og forløb fra journal-modellen.

- Journal Cache: En tidsbestemt caching af læste journal data pr. borger.

Den simpleste udgave af et kald på BFF kalder videre til CMS eller gm-facade, omformer svaret til det rette format og returnerer dette. Lidt mere detaljeret ser det sådan ud:

Der er som det ses af ovenstående mere end blot gennemstilling af kald:

- gm-facaden returnerer en FHIR model. Modellen består af en masse FHIR Observations med data i forskellige extensions. For at gøre navigationen i modellen lettere, læses FHIR modellen over i en model der afspejler den logiske model mere direkte, dvs. man kan tilgå data på mere sigende vis, fx

prf.allergiskDiposition().barnDisponeret(). Dette sker iSearchBundleTranslatorog returnerer enUnstructuredJournal. UnstructuredJournalindeholder stadig alle borgerens dokumenter i ustruktureret form. Da der ikke er et eksplicit forløbsbegreb, er vi nødt til at forsøge at samle dokumenter i grupper der er samme forløb. Dette foregår iCarePathExtractor, der udleder forløbsperioder ud fra registrerede terminsdatoer og fordeler dokumenter i de forskellige forløb.- Endelig skal data formateres om fra

UnstructuredJournaltil operationens API. For de helt simple operationer foregår det bare direkte i controlleren, men for mere avancerede strukturer foregår det i en mapper, alaBackgroundInfoJournalDataSetMapper.

Ovenstående sekvensdiagram ignorerer to yderligere kompleksiteter, nemlig cachen af journaldata og sammenstilling af journaldata med CMS indhold. Sammenstilling af data foregår ved at data hentes fra CMS (fx i dette tilfælde ordforklaringer) og fra gm-facaden, og i mapperen plukkes data så fra hhv. CMS'ens eller gm-facadens returnerede data.

3.2.1. Cache

Svar fra gm-facaden caches i lokal database for gm-bff.

Nøglen til opslag i cachen er borgerens CPR (taget fra bearer token) kombineret med BFF'ens release nummer. Dette sikre at en ny version af gm-bff vil invalidere cachen og data hentes igen fra gm-facade.

Cachen er tidsbegrænset, dvs. en cachet værdi genbruges kun hvis den er hentet for nyligt. Hvor lang tid cachen skal gælde er konfigurerbart, men er i udgangspunktet konfigureret til en halv time. Dog er det lavet sådan at hver gang man bruger data nulstilles uret. Så hvis man læser journalen op og lægger den i cachen, og så læser den igen 20 minutter senere, vil den så igen gælde 30 minutter derfra, altså 50 minutter i alt, hvis den ikke tilgås igen inden.

Cachen ryddes op løbende af et baggrundsjob, der kører hvert 5 minut (konfigurerbart). Jobbet finde alle indgang der er udløbet og slette dem fra databasen.

3.2.2. Sikkerhed

REST servicens API er delt i åbne og lukkede endpoints. De endpoints der ikke involverer persondata, er åbne og kræver ingen adgangskontrol.

For de lukkede endpoints er adgangskontrollen baseret på bearer token sikkerhed i form af json web tokens med standarden JTP-H. Tokens valideres for gyldighed, for issuer og for om de har det forventede scope. Det givne token sendes i øvrigt videre med til kald på gm-facaden.

BFF'en kobles på sundhedsdatanettet til al adgang til NSP'en.

3.2.3. Driftsmiljø og netværk

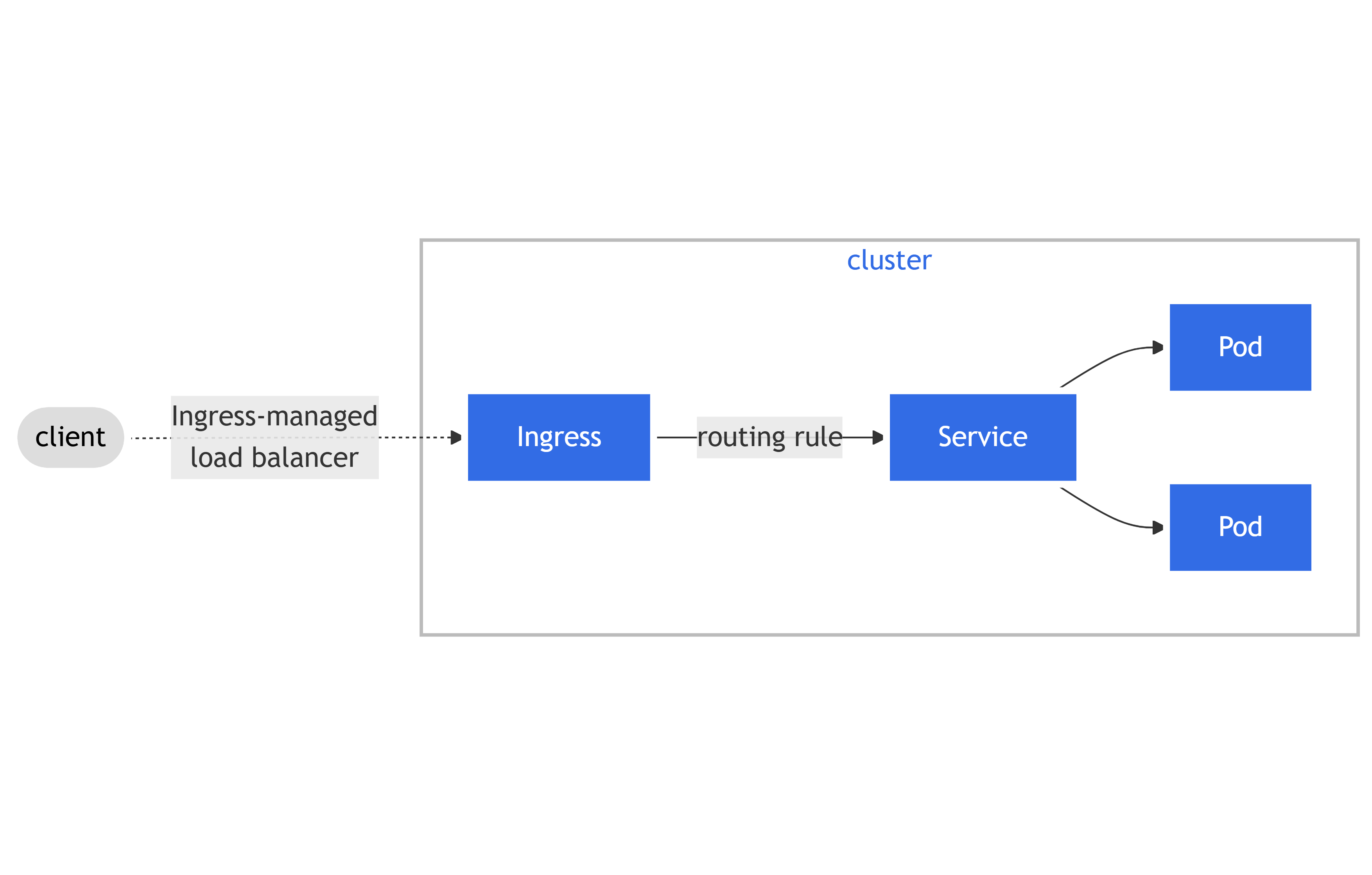

BFF og CMS driftes separat fra NSP, i et TCS (Trifork Cloud Stack) Kubernetes miljø. Al indgående og udgående trafik går gennem Kubernetes Ingress, hvor udstillede end points, routing, TLS terminering og IP-whitelisting håndteres.

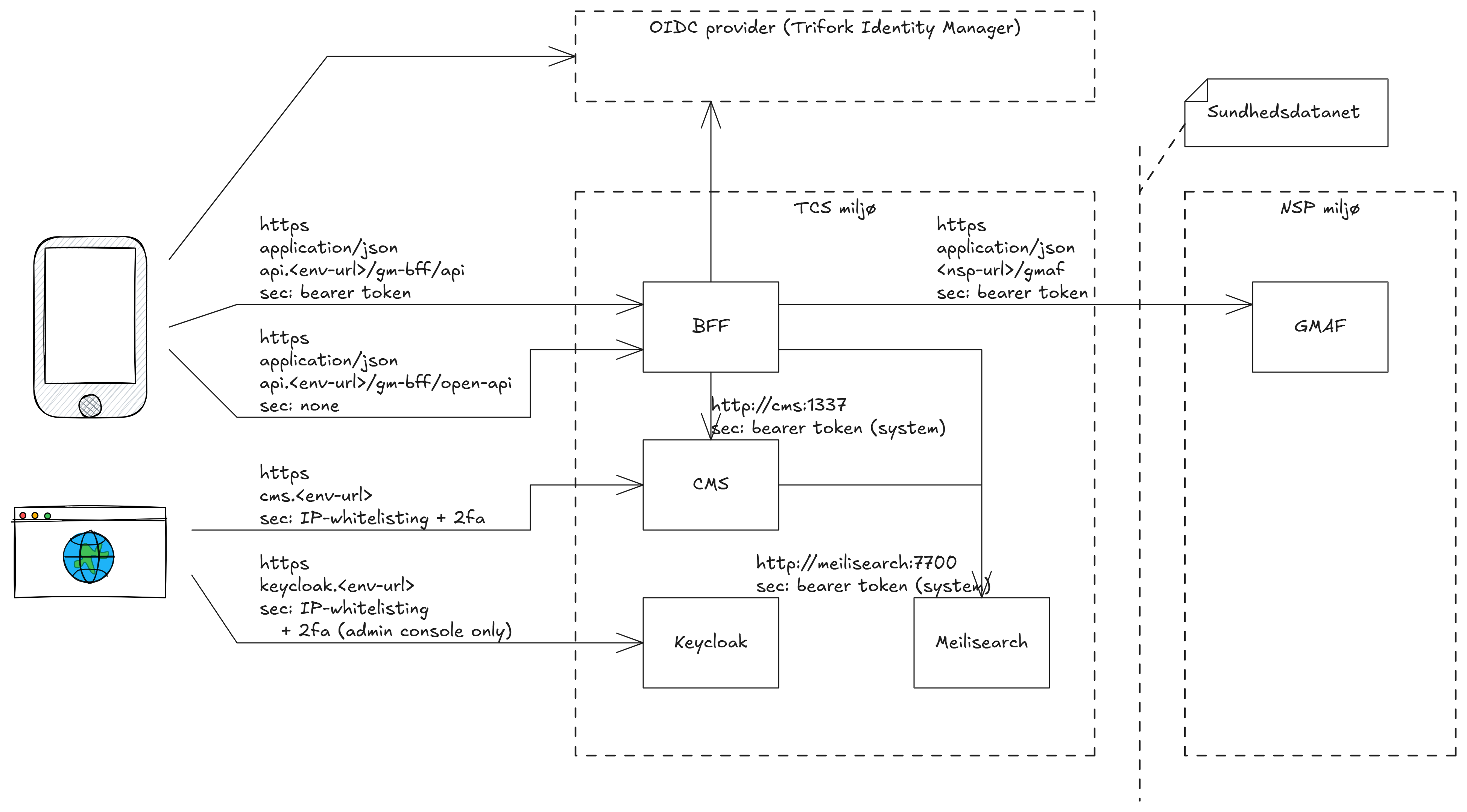

BFF'en og de omkringliggende komponenter i driftsmiljøet, og hvordan de kommunikerer, er vist i nedenstående diagram.

Her illustreres hvordan appen tilgår OIDC providere og hhv lukkede og åbne endpoints på BFF'en, mens CMS Admin konsollen tilgår CMS komponenten, samt Keycloak til to-faktor login.

BFF komponenten udstiller lukkede endpoints, der kræver en gyldig JTP-H bearer token (til alt der indeholder persondata), og åbne endpoints, der ikke har nogen sikkerhedskrav (til artikler mm. fra CMS'en). Begge grupper af end points udstilles kun på HTTPS.

Internt i TCS driftsmiljøet, snakker komponenterne sammen via interne definerede netværk, der er konfigureret i TCS miljøet og ikke tilgængelige udefra. Disse kommunikerer via HTTP for at mindske overhead. CMS'en opdaterer Meillisearch indexet ved opdateringer til artikler, og BFF tilgår CMS servicen og Meilisearch indexet.

BFF'en snakker med OIDC provideren ved validering af tokens, og endelig snakker BFF'en med GMAF (GM facade) på NSP. Al kommunikation til NSP foregår via tilkobling til sundhedsdatanettet.

4. Dokument Historik

| 3/4 2025 | Martin Henriksen/SDS | Etablering af dokumentation |

| 22/7 2025 | Anders Ringsmose/Trifork | Beskrivelse af arkitektur |

| 15/9 2025 | Thomas Glæsner/Trifork | Mindre rettelser |